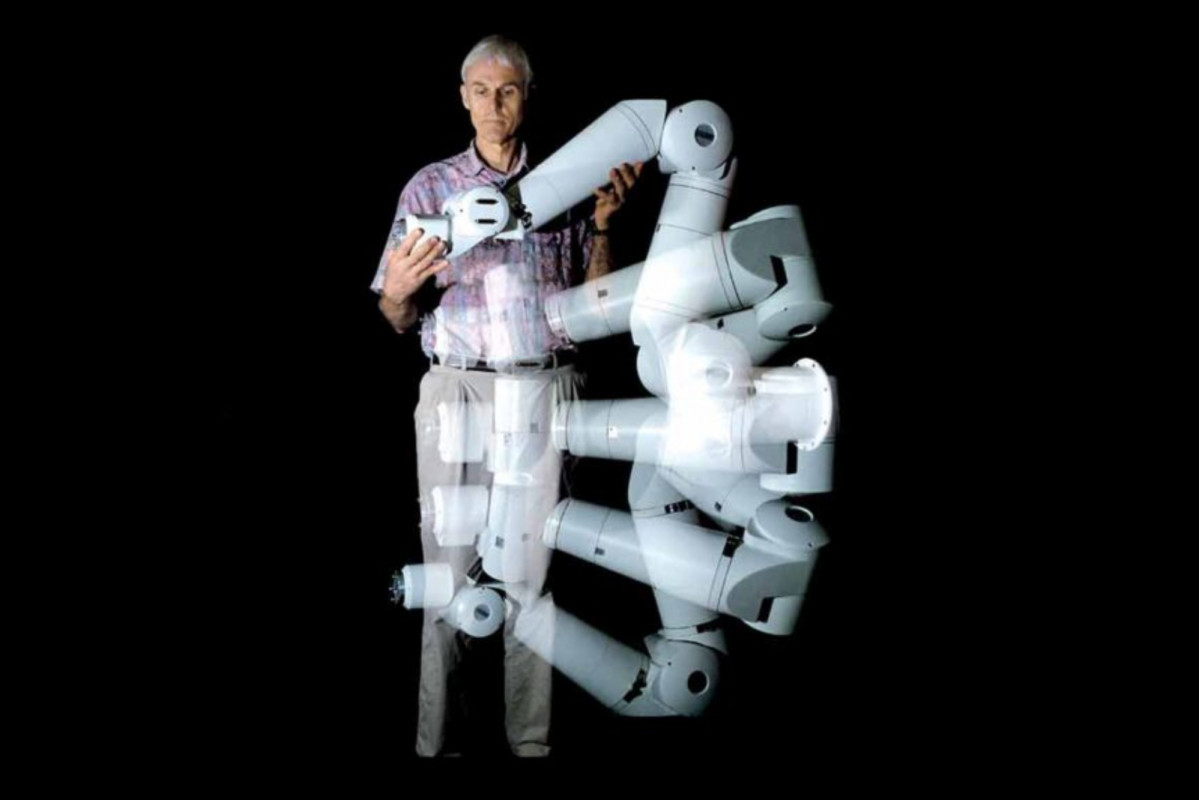

Las máquinas inteligentes no razonan

Un nuevo estudio postula que los actuales modelos amplios de lenguaje sólo se limitan a identificar patrones de datos

La inteligencia artificial es un concepto de moda en estos días, y buena culpa de ello la tiene la popularidad que han cosechado desde hace un par de años los denominados modelos amplios de lenguaje (del inglés large language models LLM), cuyos más conocidos exponentes son Gemini de Google, LLaMA de Meta o ChatGPT de OpenAI, sin duda el más utilizado por el público. Se trata de una aplicación de la inteligencia artificial llamada generativa porque consigue que estos programas informáticos generen algún tipo de contenido a partir de enormes cantidades de datos que se utilizan para su entrenamiento. Probablemente, su éxito se debe a que, por primera vez, las personas sin conocimientos técnicos pueden utilizar este tipo de servicios inteligentes, ya sea para obtener información en un formato de documento correctamente redactado, ya para crear imágenes o vídeos, por poner unos pocos ejemplos. Y todo ello utilizando el lenguaje natural, pues son sistemas que entienden nuestro lenguaje y son capaces de responder con él.

Para muchos -entre los que se encuentra Sam Altman, el director ejecutivo de OpenAI- estos llamativos modelos de la inteligencia artificial generativa son la antesala de la inteligencia artificial general, es decir, aquella que igualaría o superaría las funciones promedio de un cerebro humano. Según esta corriente de opinión estaríamos a un paso de la singularidad o el punto en la línea temporal del desarrollo tecnológico en el que las máquinas superan a los humanos. Pero no todos los expertos están de acuerdo con esta visión, y cada vez hay más voces que defienden que la inteligencia artificial actual no es otra cosa que una herramienta estadística con un potencial descomunal para procesar ingentes cantidades de datos.

Un reciente estudio llevado a cabo por tres expertos de Apple (GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models) parece confirmar las limitaciones en la capacidad para razonar de los LLM. En concreto, el trabajo ha sometido a prueba a una serie de sistemas basados en esta tecnología para resolver problemas de matemáticas que requieren un razonamiento paso a paso, utilizando el cuestionario Grade School Math 8K. La conclusión de la investigación empírica avala la tesis de que los modelos amplios de lenguaje no son capaces de llevar a cabo un razonamiento matemático formal, aunque aparentan comprender los símbolos y parecen poder trabajar con ellos hasta cierto punto.

No obstante, lo que realmente lleva a cabo uno de estos algoritmos es un proceso probabilístico de identificación de patrones y de búsqueda de datos entre los que ha recibido en su entrenamiento, pero sin entender los conceptos. Los ensayos demuestran que estos modelos pueden arrojar distintas respuestas cuando se les presenta la misma pregunta de distintas formas. En concreto, cuando a una misma pregunta se le añaden cláusulas adicionales que no afectan al proceso de razonamiento requerido para solucionarla -son irrelevantes-, la eficacia en el desempeño de los modelos cae en picado y, por tanto, también lo hace su fiabilidad.

El estudio concluye que no se ven trazas de razonamiento en los LLM: “no hemos encontrado ninguna evidencia de razonamiento formal en los modelos de lenguaje…Su comportamiento puede ser mejor explicado por una sofisticada identificación de patrones-tan frágil, de hecho, que cambiar nombres puede alterar los resultados un ~10%”. Parece que habrá que esperar para ver una inteligencia artificial que realmente comprenda el mundo que le rodea, como hace el cerebro humano, y que no se limite a manejar con eficiencia ingentes cantidades de datos.

Escribe tu comentario